هشدار علوی عضو شورای شهر تهران | رشد فرهنگ الگوریتمی و ایجاد حباب اطلاعاتی علیه فرهنگ انسانی

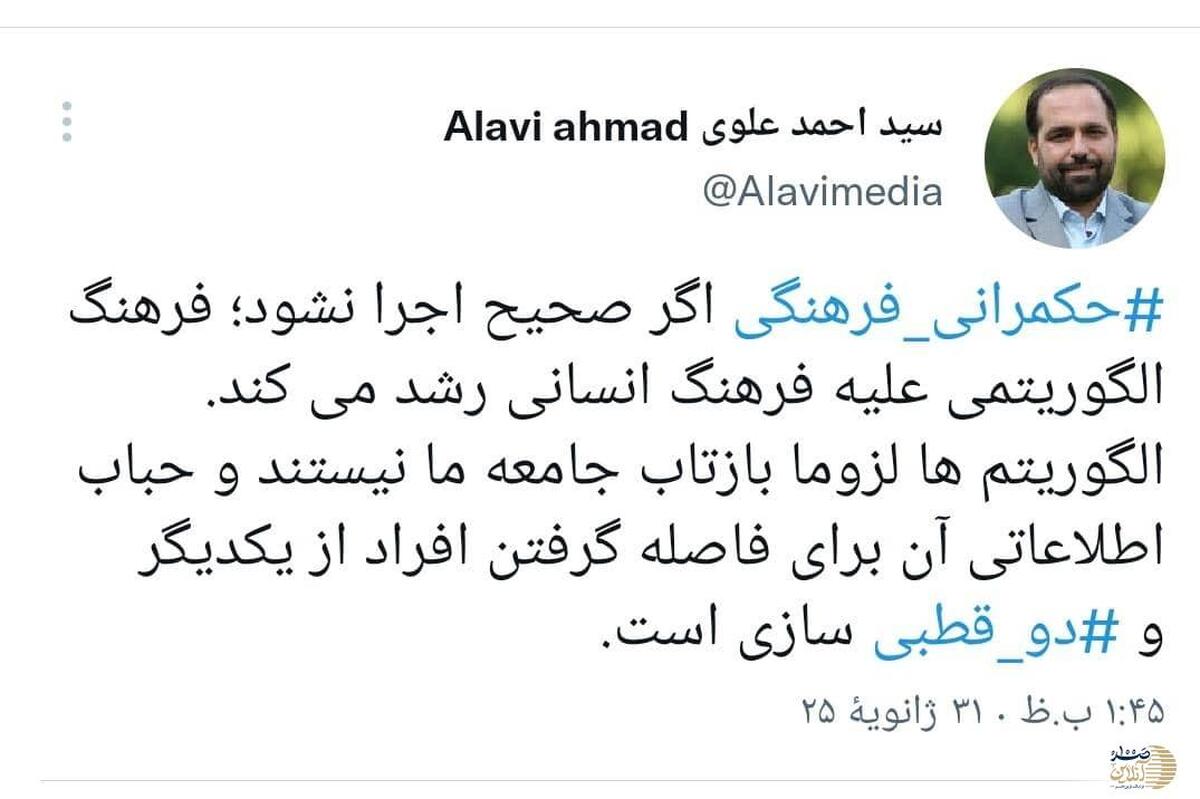

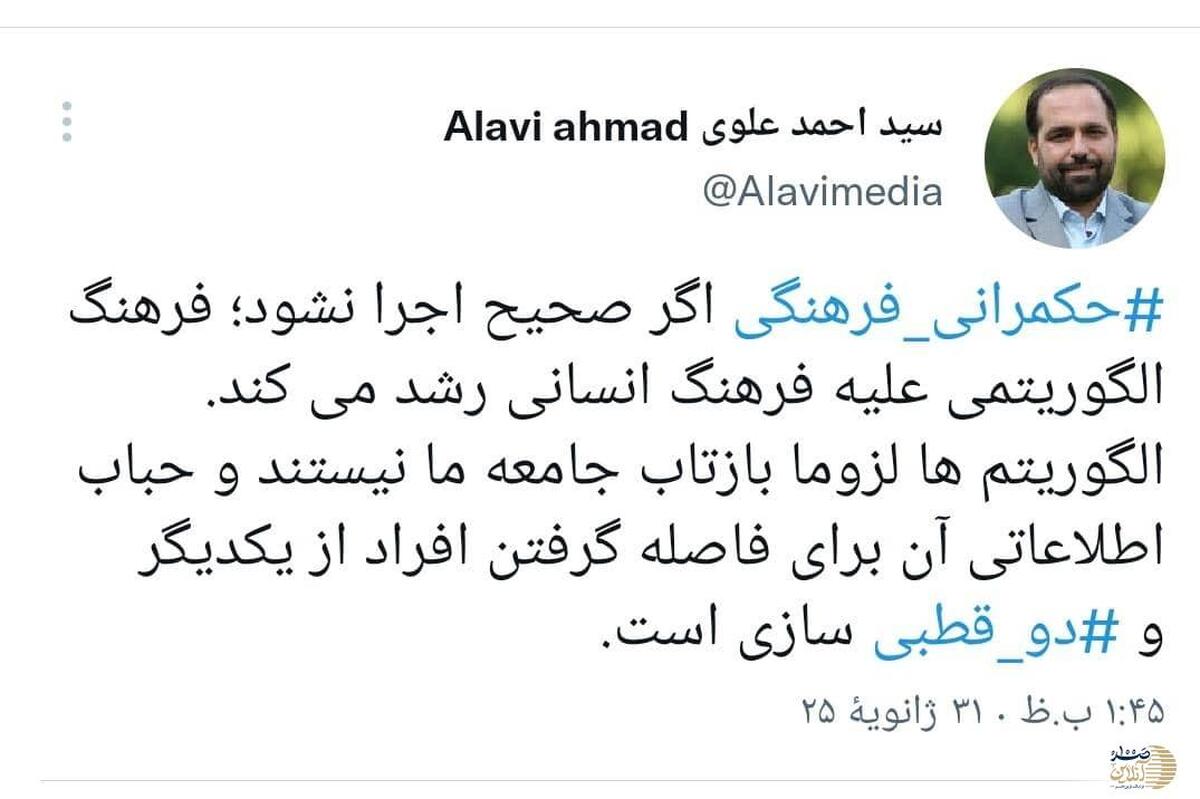

به گزارش صد آنلاین ، سیداحمدعلوی عضو کمیسیون فرهنگی شورای اسلامی شهر تهران در شبکه اجتماعی خود نوشت :رشد فرهنگ الگوریتمی و ایجاد حباب اطلاعاتی علیه فرهنگ انسانی می تواند به فاصله گرفتن افراد جامعه و به دو قطبی منتهی شود.

فرهنگ الگوریتمی چیست؟

به گزارش خبرنگار صد آنلاین ، همیشه اینگونه نیست که مردم حضور و سیطره الگوریتمها را احساس کنند. گاهی افراد جامعه، الگوریتم را به مثابه طبیعت و امر عادی تلقی میکنند.

شاید انسانها به توصیههای یک الگوریتم بیشتر از نسخه یک پزشک اعتماد کنند. تا جایی که برخی ممکن است الگوریتم را همچون وحی درنظر بگیرند. این امر باعث گره خوردن هرچه بیشتر تفکر و رفتار ما به منطق الگوریتم شده است.

تد استریفاس، استاد ارتباطات در آمریکا، از این شرایط به عنوان «فرهنگ الگوریتمی» یاد میکند. او کتابی که با همین عنوان دارد که مفصل به این موضوع پرداخته است. استریفاس معتقد است امروزه فرهنگ انسانی، به فرایند الگوریتمی پیوند خورده. درواقع فرهنگ الگوریتمی، فرهنگ انسانی را تحت تأثیر قرار داده است.

استریفاس، فرهنگ الگوریتمی را استفاده از فرایندهای محاسباتی برای مرتبسازی، طبقهبندی و اولویتبندی افراد، مکانها و اطلاعات تعریف میکند که رفتار، تفکر و احساسات انسانها را تحت تأثیر قرار میدهد. اما آنقدر وجود الگوریتمها زیاد شده است که شاید متوجه حضور آنان نشویم؛ درست مانند یک ماهی که متوجه آب نمیشود.

حباب اطلاعاتی

پذیرش بیچون و چرای الگوریتمها مشکلات متعددی به وجود میآورد. الگوریتمها محصول برنامهنویسی و کدگذاریهای انسانی هستند، از همین جهت سوگیری و تعصبات انسانها بر روی ایجاد یک الگوریتم تأثیر میگذارد. الگوریتم میتواند تبعیض و نابرابریها را تقویت کند. یک الگوریتم توانایی این را دارد که اخباری را سانسور، و اتفاقات غیر مهم را پررنگ کند. هرگز نباید الگوریتم را یک سیستم خودکار و خنثی تلقی کنیم. برای تحلیل بهتر یک الگوریتم میتوانم اقتصاد سیاسی پشت آن را در نظر بگیریم. چراکه این مسأله بر روی نتایجی که یک الگوریتم منتشر میکند تأثیر میگذارد.

یک الگوریتم همچنین میتواند برای مدیریت رفتار انسانی استفاده شود. استراتژی شخصی سازی، به شرکتها کمک میکند تا سلایق شما را بشناسند و با توجه به علایق شما، سیاستگذاری کنند. پلتفرمها از این طریق میتوانند شما را به خود معتاد کنند. شخصی سازی توسط الگوریتمها منجر به قرارگرفتن مخاطب در یک حباب اطلاعاتی میشود. از بزرگترین مضرات حباب اطلاعاتی، فاصله گرفتن افراد جامعه از یکدیگر است.

آنان به دلیل اینکه با نظرات مخالف خود روبرو نشدهاند، تصور میکنند که جامعه، فقط یک قشر دارد و از درک تکثر و سلایق مختلف در جامعه محروم میشوند. مستند معضل اجتماعی، فاصله گرفتن دموکراتها و جمهوری خواهان آمریکا از یکدیگر را به خوبی روایت کرده است. در واقع حباب اطلاعاتی از مهمترین عوامل دو قطبی شدن بین این دو گروه در آمریکا است.

البته باید گفت که الگوریتمها همیشه بر اساس سلایق ما عمل نمیکنند. گاهی ممکن است به صورت مغرضانه ما را از دیدن حقایق محروم کنند. مثلاً یک الگوریتم این توانایی را دارد تا اخبار مربوط به فلسطین دیده نشود و برعکس مطالب ناظر به همجنسبازان را بهگونهای بازتاب دهد که جامعه تصور کند اکثر افراد جامعه همجنسباز هستند.